Atariゲームの予測画像(worldModel)上で方策改善が効率的であった論文を読んでみる

David HaがVAEで一旦抽象化して生成した擬似動画をWorldModelと称し、このWorldModelの擬似動画での訓練が実画面でも効果があった事を報告している。

夢で学習する強化学習モデルの論文を読む - mabonki0725の日記

今回読んだ論文は複数のAtariゲームでのWorldModel上での訓練が極めて効率的であることを示しており、VAEで一旦抽象化して生成した空間(worldModel)での訓練が一般的に有効なことを示していて大変意義のある論文と思われる。著者等はこのモデルをSimPle(Simulated Policy Learning)と名付けている。

[1903.00374] Model-Based Reinforcement Learning for Atari

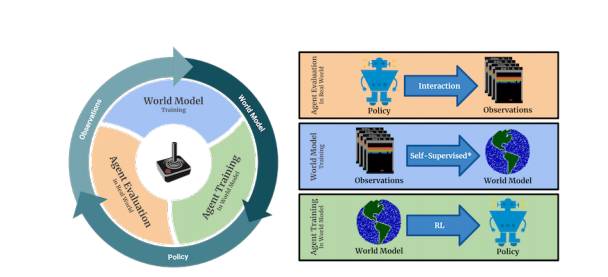

今までの強化学習はゲームに依存しないModel-Freeな探索型のモデルであったが、相当学習時間が要する事が知られている。この論文は複数のAtariゲームでも次の図の様にVAEで生成した擬似空間のWorldMode上の訓練と実画面の訓練を繰返すことで、Model-Freeに比べ相当な学習効率がある事を示した。右図の上段は訓練された方策で操作した実画面での操作推移で、中断では実画面の推移からVAEでWorldModelを生成し、下段はWorldModel上で方策

の改善をしている。左図はこれを再帰的に繰返している事を示している。

VAEでの強化学習はModel-Baseと称し、次の論文にある様に系列上の潜在変数を収束させ、この潜在空間での訓練する方式であったが、

深層ベイズモデルによる長期予測での強化学習の論文を読む - mabonki0725の日記

動画の状態推移を予測する強化学習の論文を読んでみる - mabonki0725の日記

このModelはDavid HaのWorldModelと同じ生成した擬似空間上での方策をPPO(Proximal Policy Optimization)で改善しており、表題がModel Baseとあるが、擬似空間上ではModel-Freeであり、Model-BaseとModel-Freeの統合Modelとも云える。

人間の学習には汎化能力があり、一つを習得すると同じ様な課題は容易に可能になる。これは個別の課題に対応しているのではなく、同様な課題の背後にある汎用的な構造を理解し訓練しているからで、即ちこの構造をVAEのencoderが抽象化する潜在空間であり、VAEのDecoderが生成する多様な擬似世界での訓練が現実の多様性での訓練を実現していると考えられる。

・VAEモデル

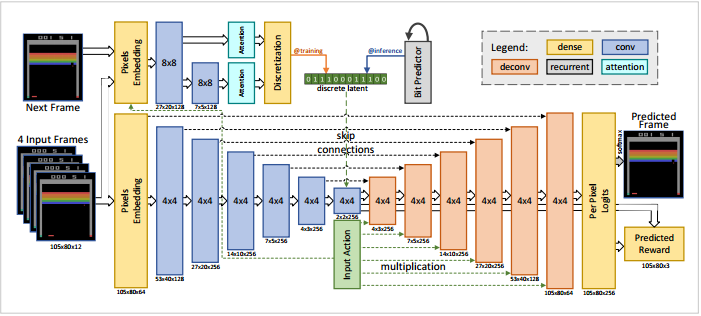

既にVAEによる強化学習の効率化は周知のことになっているからか、この論文の難易度は高く、下図に示すVAEによる潜在空間を如何に生成するかがアイデアが要旨になっている。

上図に示す様にModelは上下の2段で構成されている。下段は左側からゲームの推移画面(4フレーム)をVAEに入れて中央が潜在空間になっており、右側に予測の次画面と報酬を出力している。また中央に入力画面での操作(行動)をベクトル化して入れている。従ってこのVAEは左側の4実画面と右側の次フレーム画面と実報酬が一致する様に潜在空間を最適化していると考えられる。

上段の左は下段の4フレームの次のフレーム画面を入力としてAttensionで潜在変数を生成しているが、この安定のため上段の左のLSTMより潜在変数の系列に合う様に拘束している。そしてこの潜在変数は下段の中央の潜在空間に反映している。

・方策の改善

方策はPPO(Proximal Policy Optimization)を使っている。これは行動や状態の推移が実数領域でのTRPO(Trust Region Policy Optimization)の改良型であり複数のAgentの報酬を集約して訓練するモデルである。しかしゲームの状態は離散状態しかとり得ないので実領域のPPOは必要ないと思うが、TRPOの提唱者のLavinが著者に入っているので、このPPOのモデルに使い馴れているためかもしれない。PPOは16個の並列のエージェントを使い、訓練は50フレーム毎に行うが、50フレームは訓練には短いので最後のフレームには擬似報酬をPPOで得られた価値で与えている。

最上図にある円のサイクルは15回となっていて、WorldModel上の訓練は225ステップが最も良かったと報告している。16個のエージェントによるPPOの繰返しは80万回の数倍で都合1520万回繰返している。

・実験結果

多くのAtariゲームについてModel-Free型の最も学習効率がよいアンサンブル型のRainBowとPPO独自のモデルと比較している。

DeepMindのDQN統合版のRainBowの論文を読む - mabonki0725の日記

DeepMindの多様な環境で順番学習の有用性の論文 - mabonki0725の日記

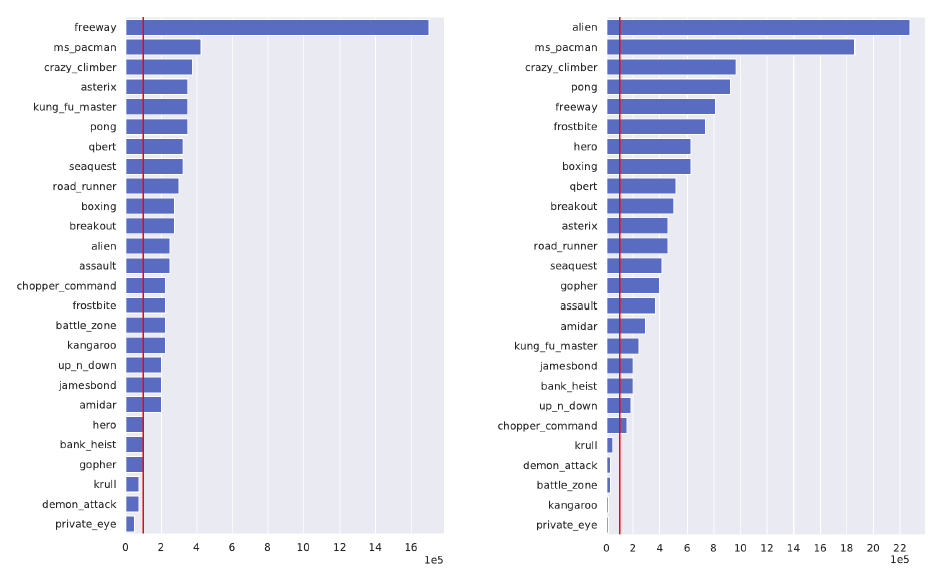

下図の左がRainbowで右がPPO独自との比較で、各ゲームについて本方法(SimPLe)が10万回(赤線)で得た報酬を得るのに要した比較手法での回数である。単位は10万回

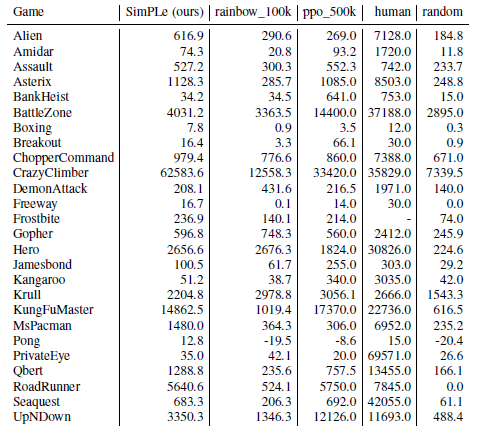

次の表はSimPleで学習サイクルを15回行った報酬(5回の試行の平均)と、RainBow10万回 PPO50万回及び人間の平均スコアとランダムなモデルの比較である。大体RainBow10万回より優れていることが分る。

このモデルは実ロボット型のPPOをworldModel上で訓練しているので、実ロボットの視野画面を使ったロボットの学習には有効と考えられる。Lavinも参加しているので次はこの分野の論文が期待される。