動画の状態推移を予測する強化学習の論文を読んでみる

動画から系列型のVAE方式による状態推移を予測する強化学習として、優秀な学習効率を達成したモデルの論文である。

[1811.04551] Learning Latent Dynamics for Planning from Pixels

系列型VAEの強化学習モデルWorld Modelを最初に発表したDavid Haも著者になっているので、このモデルはWorld Modelの発展型もしれない。

この成果については下記のICMLの口答発表がある。

Learning Latent Dynamics for Planning from Pixels

GitHubにも著者らの実装と動作した動画が揚がっている

GitHub - google-research/planet: Learning Latent Dynamics for Planning from Pixels

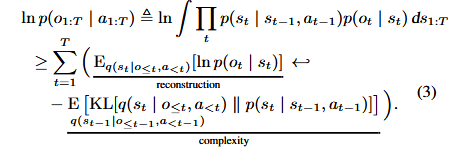

この強化学習ではエージェントが一部しか観察できないPOMDP(Partial Observable Markov Dicision Process)となっていて、次の分布のパラメータ推定をELBO(evidence lower bound)の最大化で推定している。従ってこれらの分布は全て多変量ガウシアンである。

推移モデル

観察モデル

報酬モデル

Encoder 状態

は潜在変数となっている

摂動

論文にある全体のアルゴリズムとしては潜在変数の最適化とサンプリングの組合せで以下となっている。

以下を収束まで繰り返す

次の潜在変数の最適化を繰り返す

保存された行動軌跡図からバッチ分をランダムに取り出す

ELBO(Equation3)でを解き事後分布の状態潜在変数のパラメータ

を求める

パラメータを更新する

サンプリングを繰り返す

状態潜在変数をEncoderで推定する

推定された状態に行動計画より最適行動を求め、これに摂動を与える

アルゴリズム2参照

行動をR回繰り返し、

報酬と観察図

を得る。

繰返した観察図より軌跡図として保存する

アルゴリズム1中にあるの推定の理論は(Equation3)として以下に手案されている。(式の展開は付録8式参照)

左辺の対数尤度を右辺では潜在変数とを介在させて

が一致する様にELBOを解いている。

しかし長い系列のELBOは容易でないので、RNNを採用したRMMSで実装している。

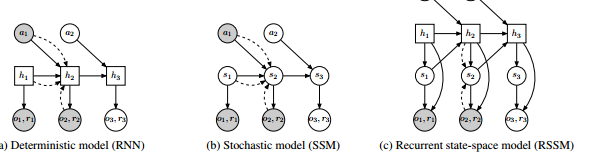

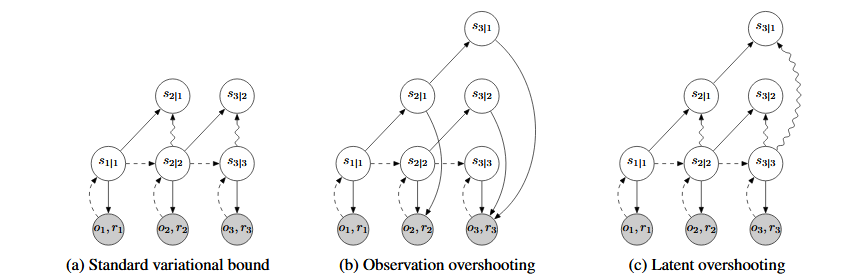

著者らは下図の状態遷移SMMとRNNを合成したRSSM(Recurent State Space Model)を提案している。即ち非線形の状態遷移では誤差が大きく再帰的なRNNの経路を追加して安定化を図っている。ここでSSM(統計的過程)とRNNを(決定的過程)を合成したと言っている。

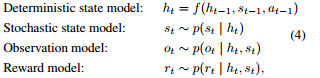

よってRNNの隠れ変数を使って以下で推定している。

上記を使って便宜的に変分を以下に簡略している。

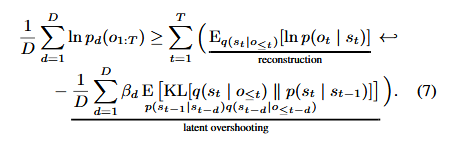

さらにEquation3での1step毎の推論をdステップ毎の推論(Latent Overshooting)に拡張している。

下図はlatent Overshootingのd=3の実装図である。左端が1step毎で右端が3step毎の予測となっている。

・行動計画行動分布の推定

探索型の価値関数を使わず今まで良い報酬が得られた行動の分布とd-step先の予測から、最適な行動分布を求めている。これについては付録にアルゴリズム2として次の様に記述されているが、要は報酬が良かった行動を集め、このガウス分布を求めているだけである。

行動軌跡を記録する

良い報酬が得られた行動のガウス分布から行動

をサンプリング

d-step先の予測

d-step迄の報酬

行動軌跡から報酬が高いK個のベストの行動軌跡を取り出す。

ガウス 行動推分布の平均と分散を計算する

平均

分散

・実験結果

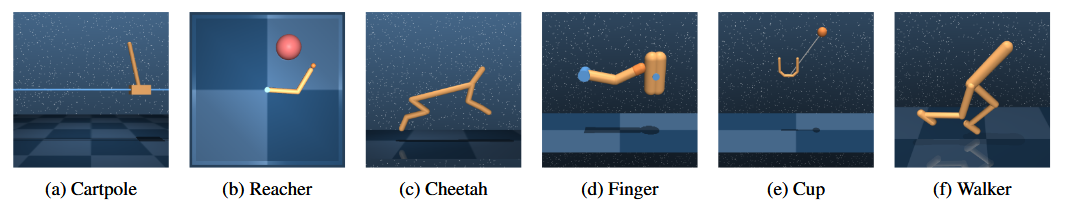

実験対象としては行動が実数領域で制御できる下図のDeepMindの6個の課題としている。

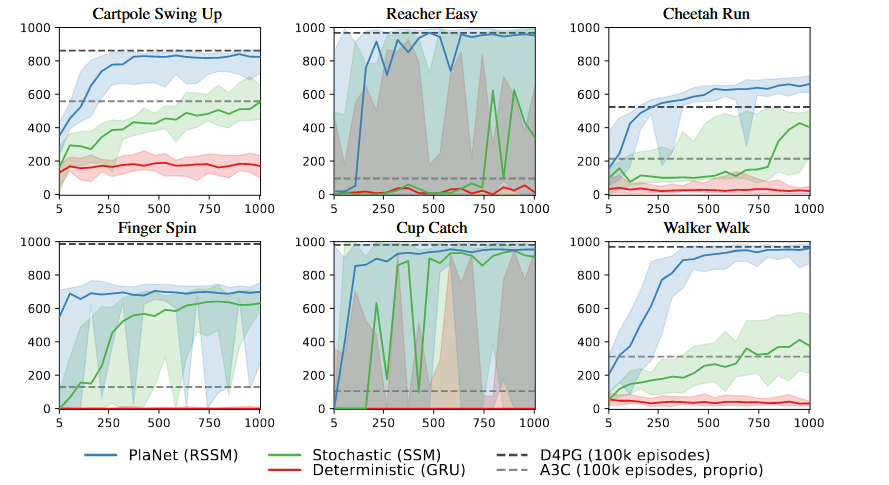

実験結果は何れの課題でも200個程度の学習で10万回学習したD4PGのレベルに達しており学習効率が優れていることを示している。

注)DP4Gは実数領域のActor-Critic版のDDPG(Deep Determistic Policy Gradient)を改良したもの

・感想

このモデルの特質は動画より状況を予測して効率のよい強化学習を達成していることである。

しかしモデルはVAEのELBOで解く為、潜在変数も行動分布も全てガウシアンになっている。この様な分布が適用できるのは状態推移が一様な課題しか適用できず、ゴールがある様なゲームは容易でないと思われる。しかし実務上の課題は最適な一様状態に達する工夫であり、この様な状態に移行する学習には適用できると考えられる。