異言語間で画像を基に会話で翻訳モデルを構築する論文を読む

本来の異言語間の会話は、最初は同じ物を指して互いの言葉を言い合ったのが始まりで、互いの交流の中で細かいニュアンスまで理解する様になったのは想像に難くない。

今回の翻訳モデルは上記の過程を深層学習でモデル化したものである。従来の翻訳は構文解析や言語列の対応関係から行われてきたが、写真を媒介にした共通認識もとに言語を学び合うシステムで記号創発モデルでもある。対話を考慮しない言語モデルなんてずっと違和感があったが、やっと出現した感がある。

[1710.06922] Emergent Translation in Multi-Agent Communication

有難いことに説明の図は英語と日本語の例で示してある。(これは東大の中山研究室の論文を参照しているためと思われる)

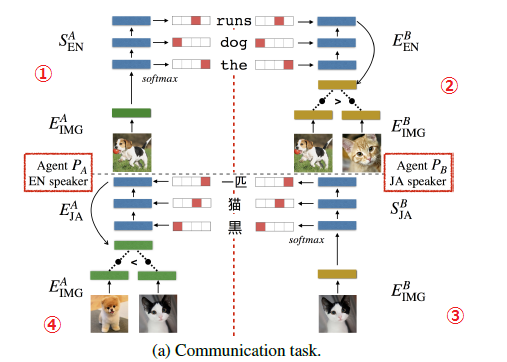

構成としてはGANと同じ様な構成で英語→日本語 日本語→英語と①~④で循環しながら精緻化するモデルである。

①では画像を一つ選び、画像をEncode-Decodeとして英語にする。

②では逆に英語をEncodeして選択された画像を当てる。この遣り取りを繰返し深層学習のEncoderとDecoderを当たる様に訓練して英語を日本側で理解するモデル化を行う。

③では反対に日本語側で画像を選択し、これを日本語にDecodeする。

④では英語側で日本語をEncodeして選択された画像を当てる様に深層学習を訓練する。

この様に多様な写真を当てる訓練をしたEncoder→Decoderを使って翻訳システムを構築している。下図のEncode先(Decode元)は意味構造を示していると考えられる。

・結果

この翻訳は言葉ベースと文章ベース(上図)での実験があり、言葉ベースでは以下となっている。

左図は学習回数についての画像の当り(2者択一)の精度(赤)とこの訓練結果を使った翻訳(英語→独語)の精度(緑)で翻訳精度の頭打ちが見られる。

右図はベンチマークとの比較 表中のP@XXはResNetに入れるベクトルの幅と思われる。

このモデルは画像→文書生成、文書→画像生成はCNNとLSTMで出来ることは実証済みなので、これを統合したモデルとも考えられる。

このモデルの本当に面白いのは2対モデルから多数モデルに簡単に拡張できることにある。以下は英語・独語・仏語の3対モデルと実験結果である。実験結果では3対モデルが2対モデルより学習精度が良いことを示している。

ヨーロッパやブラジルの様に近親者が複数の異言語を話す場合、幼児が簡単に多言語を習得している。これは言語間を翻訳しているのではなく、イメージを媒介とした多言語の習得が効果的である事を実験でも裏付けている。