文体のパターンの繰返しで深層学習する論文を読む

ランニングできず 英語できず

(1) 文体のパターンの繰返しで深層学習する論文を読む

「Dynamic Evaluation of Neural Sequence Models」 https://arxiv.org/abs/1709.07432

一般に自然言語の深層学習では単語間の繋がりをLSTMで学習することが殆どですが、近年構文を学習するHocherのモデルや意味データベースを使って解析を強化するモデルも出現してきています。

この論文は長文の構造が似た文体が繰返し出現することに注目し、文体を表す隠れ変数で生成される文が連結して構成されるとして解釈するモデルです。

このモデルをdynamic evalと称しています。

文体を表す隠れ変数を仮定すると文章の尤度は次式となります。

ここで

:文章全体

:文 or 固定長の文字列

:文体を表す隠れ変数

:文章全体を表す隠れ変数

このモデルでは下図の様にRMSprop型を修正した深層モデルで

隠れ変数を解いています。

この論文では明記されていませんが下図のmodel(si,θi)はLSTMと解釈されます。

(1.1)手法

自然言語の深層学習にはRNNやLSTMを使うのが一般的ですが、文体間の生成モデルなので深層学習のパラメータ更新タイプのRMSpropの更新規則を改修し使っています。

このパラメータの調整は一般のニューロモデルと同じです。最終的に生成した文章と実際の文章の相違より逆伝播してパラメータを調整しています。

但しパラメータの更新規則はRMSpropの修正版を使っています。

RMSpropの更新規則は以下です。

このRMSpropを以下に置き換えしています。

また 文体の連鎖を計算するため以下を計算します。

:

の生成規則で生成した文と実際の文

との相違による損失量

ここからRMSpropの各項を計算します。

よって上記の置き換えを適用すると

各は文章全体の隠れ変数

に収束する必要があるので、

上式のRMSpropの更新規則に正則化項としてこの制限を追加しています。

ここで

(1.2) 結果

Penn Treebank の文章でのPerplexityは以下の結果となっています。

Perplexityは文の複雑性を表し少ない程よいとされています。

ここで LSTM + dynamic evalとあるのは下図の構成になっているからです。

「Generating sequence withe recurrent neural networks」Graves (2013) より

(1.3) 感想

・の更新規則は記述に無い様です。この辺は読み落としかもしれません。

・簡単なロジックなので実装は容易かもしれませんが、LSTMの調整が難しそうです。

強化学習方程式の不確実性を報酬に取込む論文を読む

テニス2時間 英語できず

(1) 強化学習方程式の不確実性を報酬に取込む論文を読む

「The Uncertaintry Bellman Equation and Exploration」

https://arxiv.org/abs/1709.05380

この論文は強化学習を解くBellman方程式の近似解での不確実性を見積りより精緻に方程式を解き、既存のDQNを改善するものです。

モデル名UBE(Uncertaintry Bellman Equaiton)

一般に強化学習は将来の累計報酬の期待値が最大になる様に局面毎の行動を選択するモデルです。

これはBellman方程式で行動価値関数として定式化されますが、将来への漸化式で解くので行動によって無限に分岐が続く場合、近似解で解くことが一般的です。

ここで

は方策(policy)

は割引率

は報酬

は局面

は行動で方策によって確率的に決定されます

また現報酬とそれ以降の行動価値関数

の和を行動価値関数

であらわすと。

但し

(1.1) 手法

一般に何らかなの霍乱要因があると行動価値関数

と推定された行動価値関数

に差が出てきます。

この差には認識できない報酬が存在しているからと考えられます。

ここで を行動価値関数の差とすると

この二乗平均誤差は解析的に次式で表現できます

この霍乱要因による行動価値関数の差はMarcovの不等式を使うと

霍乱要因の上式の下限を隠れた報酬

として定理1を導入しています。

[定理1]

この論文は隠れた報酬をDQNに与えてモデルを改善しています。

(1.2) 結果

全ATARIゲームのDQNのスコアの中央値と不確定部分を隠された報酬とするUBEスコアの中央値との比較を示しています。

ここで

instrinsic Motivation:擬似カウント

UBE n-step:隠れ報酬をn回刻みで計算する

「Montezumaの復習」は既存のDQNでは殆ど解けないモデルです。これには画面遷移を擬似カウントとして報酬とすると旨く行くことが知られています。UBEのスコアが上回っていますが、これは擬似カウントがUBEに反映されているからです。

中国人達の深層Treeモデルの論文を読む

ランニングできず 英語できず

(1) 中国人達の深層Treeモデルの論文を読む

「Deep Forest: Towards an Alternative to Deep Neural Networks」

https://arxiv.org/abs/1702.08835

これは下図にある様にランダムフォレストを単に多層化したアンサンブル型モデルなので残念ながら理論的な新しさはありません。モデル名称はgcForest(Multi-Graind Cascade Forest)

ランダムフォレスト自体がアンサンブル型なので深層にする意味が明確でないので構造が似ているDeepLearningと比較しています。

新興の中国人達がオリジナルな理論を構築できるまでは時間がかかりそうです。

そもそもアンサンブル型の優位性はJ.Friedmanが2000年に理論的に解明しました。

またFriedmanはアンサンブル・ツリー+ブースティング+クロス・バリエーションとして各々の短所を補うモデルを提唱していて、これが現在Xgbootとなっています。

DeepLearningは深層過程に於いて逆伝播して各層が独自の役割のフィルターを形成するもので、構造が似ているからと言って比較対象するものでは無いと思います。

同じアンサンブル型であればXgboostと性能比較すべきと思います。

(1,1) 手法

このモデルは4個のランダムフォレストの深層モデルとなっていて、識別結果に入力データを再追加して次層に渡して深層化しています。

(4個の内 2個は完全なランダムフォレスト 他の2個は入力データをランダムに短くしたランダムフォレストです)

多分このモデルだと過学習の可能性があるので、各層毎にクロス・バリデーションをしています。

最後にアンサンブルで識別結果を単純平均化しています。ランダムフォレストと同様にモデルの精度が頭打ちになると深層化を停止しています。

(1.2) 結果

結構面白いのは、DeepLeanningと対抗して文章の感情分析と画像識別をしていることです。

結果はこの記述を信じれば意外に良好です

顔の認識

音楽の感情分析

(1.3) 感想

アンサンブル型なのでXgboostでも同じ様に文章や画像の分析をしてみたら面白いと考えます。

3D動画よりDoll House画像を生成する論文を読む

ランニング30分 英語できず

(1) 3D動画よりDoll House画像を生成する論文を読む

「MatterPort3D: Learning from RGB-D Data in Indoor Environments」

https://arxiv.org/abs/1709.06158

この論文は屋内をMatterPort3Dと云う動画で撮ると、深層学習により屋内をDollhouseの様に見せることができるものです。

Mattterport3DカメラはMatterport社 https://matterport.com/ が販売するものです。

1) Matterport3Dデータの特性

このデータは次の様な優れた機能を有しています。

・RGB-D Panorama

1280x1024 Colorの解像度で奥行きのデータもあります。

360度のパノラマ動画を録画します。

・Precise Global Alignment

3D認識で1cm未満の精度があります。

ここで

奥行認識は観測点から大量の粒子を吹き付けた画像です

法面表示は観測点からの面の向きによって色調を変えた画像です

・Comprehensive Viewpoint Sampling

パノラマ動画用に2m置き程度にView Point(緑点)のデータを生成します。

・Entire Buildings

90件の家の全階・全部屋の3D動画が可能

2)Matterport3Dのデータを深層学習を使って様々な認識を可能にしています。

・フロアの識別

・物体の認識と種類の識別

3)深層学習による認識の方法

・教師用データの作成

この様な認識をするため実際の画像から教師用ラベルを作成する必要があります。

教師用のデータは「Amazon Mechanical Turk(AMT)」でツールと人力で構築しています。

50811物体から1659のラベル付けをしています。

言葉の意味階層モデルWordNetを使って最終的に40に絞っています。

・画像認識 KeyPoint Matching

異なるView Pointでの同じ物体の認識のため

下図の3画像(一致用と非一致用)の教師データで訓練しています。

特徴量は512個使用 ResNet-50での深層学習

・ View Overlap Prediction

動画で同じ場面である認識をSLAMの仕掛けを利用しています。

画像と

の同じ場面かの識別は次式で行っています。

ここで

は奥行きが確かなpixel数

は実際に5cm内の範囲で

と重なっているpixelの数

写真の下段の数字は同じ場面の確率を示す

・法面認識

Matterport3Dデータは位置と奥行きのデータを持っているので容易に認識できます。

この認識にはCNNを使っています。

・局面の識別

この局面認識ではCrowd-sourcingで構築した教師データを使って訓練しています。

・立体の認識

Metterport3Dデータを1.5m x 1.5m x 3m の長方体で切り出して、

2cm刻みに小さくしていきます。これと教師データが70%以上一致すれば

教師データと同じとしています。教師データは418840個あり、ScanNetで

識別しています。

PRMLのカルマンフィルターの変換行列の学習を理解する

ランニングできず 英語できず

(1) PRMLのカルマンフィルターの変換行列の学習を理解する

「PRML 13§ 13.3.2 Learing in LDS」

カルマンフィルターの状態方程式はシステムモデルと観測モデルに分離して表現されます。

システム・モデル

但し

観測モデル

先日記述した様にカルマン・ゲインを用いて解くと

観測データから観測前のデータ

を得ることができます。

次式がこの結論でした。

但しカルマン・ゲインは

しかし解法式を見るとが所与として必要です。

下図は上式でを適当に設定しカルマン・フィルターで予測した時系列です。

推定された観測前のデータで観測データの予測

をしているので予測精度が高いことが分ります。

この場合、対象時系列は1回前のトレンドを持つと考え、

ARモデルでを計測し下式の様に変換行列

を設定しています。

ノイズ項であると

は適当に設定しました。

この様な変換行列をデータから推定できれば大変助かります。

PRMLのカルマン・フィルターの学習ではこれら未決定項をデータから推定しています。

(1.1) 手法

PRMLではEMモデルでこの未決定項を推定しています。

系列データの確率は次式で与えられます。

この対数を取ると

①の式

1) Eステップでは

②の式

2)Mステップでは

を

として微分して最大化を行います。

ここでは最も重要な変換行列を算出してみます。

についての微分なので①の式で

と

以外は定数となるので

期待値は

③の式

これを微分して方程式を解くと

も同様に微分して算出できます。

この結果をEステップにいれてと

が収束するまで繰返します。

CNN最適化の制御式を生成するRNNの論文を読む

ランニングできず 英語できず

(1) CNN最適化の制御式を生成するRNNの論文を読む

「Neural Optimizer Search with Reinforcement Learning」

https://arxiv.org/abs/1709.07417

CNNの最適化の制御式をRNNが強化学習で学習するモデルでかなり画期的なモデルです。

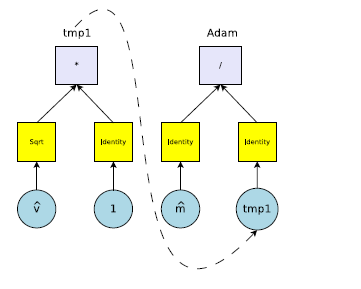

例えばCNNの最適化の仕様は次の様な重み調整の制御式で示す事ができます。

ここで

RNNが数式の構文を生成する性能に注目し、CNNが最適な精度を出せる様に制御式を強化学習するモデルとなります。

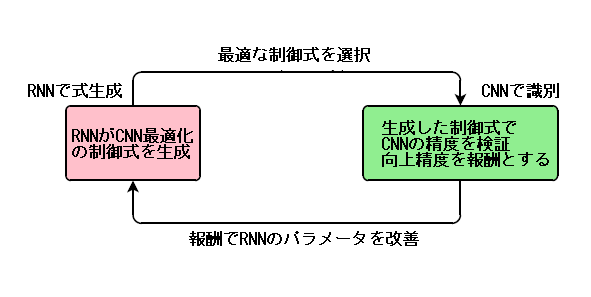

概念図は次となります。

(1.1) 手法

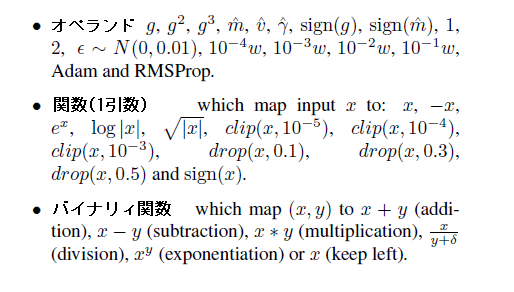

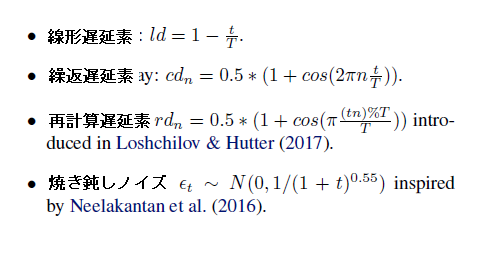

1) 制御式DSL(Domain Specific Language)の仕様

深層学習の重み調整の制御式(DSL)は下記の単位が繋がる形式で学習します。

ここで

はオペレータ

は関数(1引数)

はバイナリィ関数

は学習率

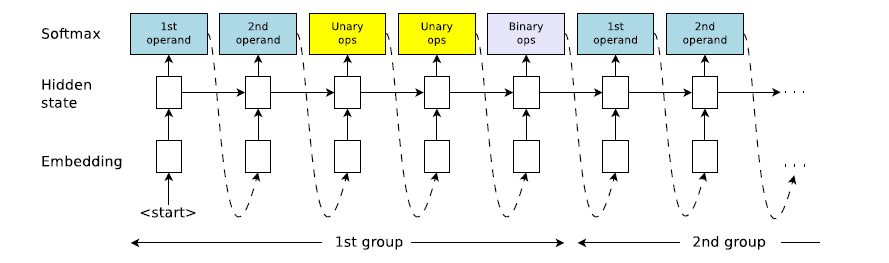

制御式は図示すると次の様な構成となります

以下に各種類の要素があります

2) RNNの構成

制御式は5つの要素が1単位として連結した構成になります。

RNNでは上式は計算順序(逆ポーランド法)になっています。

3)強化学習によるRNNの学習

RNNの強化学習の記述は次式のみです。

ここで

は最大化する目的関数です

は制御式を投入した場合のCNN精度の改善幅を示しています

は制御式の投入確率で

でパラメータ化されています

但しこの強化学習は相当時間がかかるので様々な工夫をしています。

・強化学習モデルはPPO(Proximal Policy Optimization)を採用

・CNNは簡便な学習で済ます(2層、5回繰返)

・組合わせの数はあるので無駄な組合わせを排除

それでも1日費やすとのことです。

(1.2) 結果

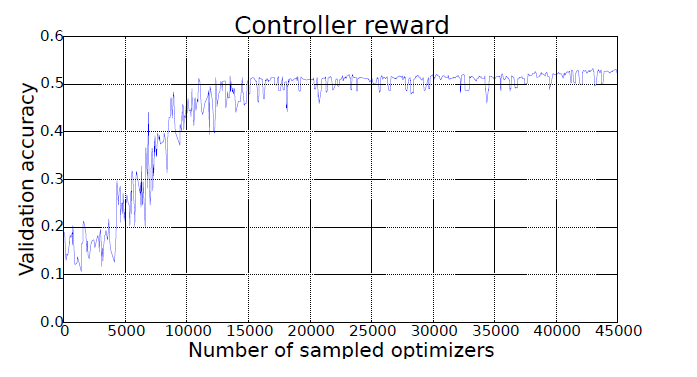

下図が強化学習を繰返しと簡便CNNによる精度の改善状態です。

10000回で収束しています。 データはCIFAR-10 CNN

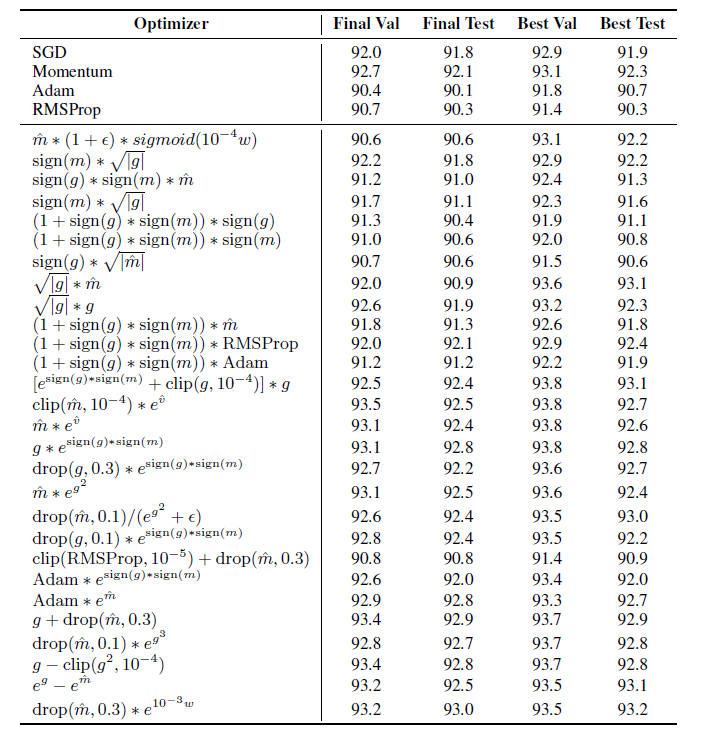

下表の様な重み調整の制御式と精度が達成されています。

識別モデルはwide-ResNet データはCIFAR-10

(1.3) 感想

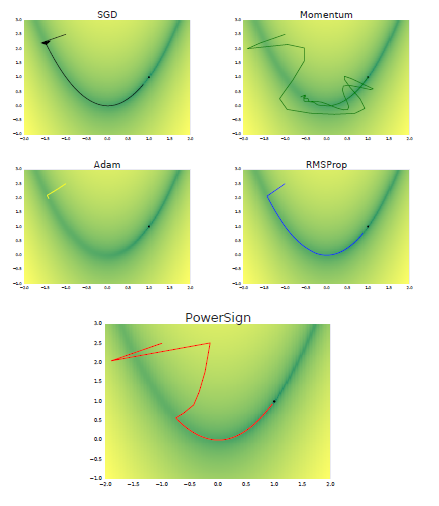

この論文では各制御式での重みの収束軌跡も添付しています。黒点が収束位置です。

素晴らしい成果と思います。この様な重み調整の制御式の試行が深層学習の解明に大きく寄与すると思えます。

DeepMindの外部メモリーによる生成モデルの論文を読む

ランニング30分 英語できず

(1) DeepMindの外部メモリーによる生成モデルの論文を読む

「Variational Memory Addressing in Generative Models」https://arxiv.org/pdf/1709.07116.pdf

この論文は深層学習の生成モデルVAEやGANで成果を出していることに対抗して、DeepMindが得意とする外部メモリを使ったより柔軟な生成モデルを提案したものです。

DeepMindはNTM(Neural Turing Machine)やDNC(Defferencial Neural Computer)で外部メモリーを組み込んだ推論を実現しており、この成果を生成モデルに応用しています。

VAEは生成データと実データの差をパラメータ化して深層学習で解消しますが、一方この論文の手法は外部メモリーに条件を設定し、この条件を満たすVAEを実現するものです。

しかも下図(左)の様に生成データと実データの差を条件とすれば既存のVAEと同じ事が出来、大変柔軟性に富んだ手法となっています。

(1.1) 手法

VAEなので条件Mを満たすを生成する隠れ変数

を変分法で求めます。

変分の下界は次式の右辺で、これが最大になる様にと

を深層学習で訓練します。

ここで

はMemory

の番地

と

は独立と見做せるので上式のサンプリング

の事後分布は次となります。

この論文はと

の事後分布を各々解いています。

1) の事後分布

ここではNTMはDNCでの外部メモリーのキーの学習と同じ考え方を導入しています。

ここで

は外部メモリーの関数

による番地の隠れ変数

は顕在データ

の関数

による隠れ変数

即ちと

の隠れ変数が近くなる様に関数

と

を訓練した結果を

として、これを事後分布

としています。

2) の事後分布

この事後分布はが離散なので簡単に計算できません。

そこでVIMCOというモデルで離散の事後分布を次式の変分で求めています。

ここで は離散のインデックスです

右辺を各々と

を微分して下界を最大化しています。

この辺までの記述になるとかなり式の展開が曖昧になっています。

(1.2) 結果

下図は学習された番地毎のメモリーの状態が示してあり、正解の図

と推定された番地

の画像が近いことが分ります。