PRMLのカルマンフィルターの変換行列の学習を理解する

ランニングできず 英語できず

(1) PRMLのカルマンフィルターの変換行列の学習を理解する

「PRML 13§ 13.3.2 Learing in LDS」

カルマンフィルターの状態方程式はシステムモデルと観測モデルに分離して表現されます。

システム・モデル

但し

観測モデル

先日記述した様にカルマン・ゲインを用いて解くと

観測データから観測前のデータ

を得ることができます。

次式がこの結論でした。

但しカルマン・ゲインは

しかし解法式を見るとが所与として必要です。

下図は上式でを適当に設定しカルマン・フィルターで予測した時系列です。

推定された観測前のデータで観測データの予測

をしているので予測精度が高いことが分ります。

この場合、対象時系列は1回前のトレンドを持つと考え、

ARモデルでを計測し下式の様に変換行列

を設定しています。

ノイズ項であると

は適当に設定しました。

この様な変換行列をデータから推定できれば大変助かります。

PRMLのカルマン・フィルターの学習ではこれら未決定項をデータから推定しています。

(1.1) 手法

PRMLではEMモデルでこの未決定項を推定しています。

系列データの確率は次式で与えられます。

この対数を取ると

①の式

1) Eステップでは

②の式

2)Mステップでは

を

として微分して最大化を行います。

ここでは最も重要な変換行列を算出してみます。

についての微分なので①の式で

と

以外は定数となるので

期待値は

③の式

これを微分して方程式を解くと

も同様に微分して算出できます。

この結果をEステップにいれてと

が収束するまで繰返します。

CNN最適化の制御式を生成するRNNの論文を読む

ランニングできず 英語できず

(1) CNN最適化の制御式を生成するRNNの論文を読む

「Neural Optimizer Search with Reinforcement Learning」

https://arxiv.org/abs/1709.07417

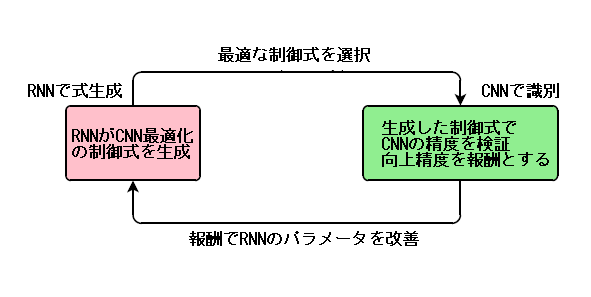

CNNの最適化の制御式をRNNが強化学習で学習するモデルでかなり画期的なモデルです。

例えばCNNの最適化の仕様は次の様な重み調整の制御式で示す事ができます。

ここで

RNNが数式の構文を生成する性能に注目し、CNNが最適な精度を出せる様に制御式を強化学習するモデルとなります。

概念図は次となります。

(1.1) 手法

1) 制御式DSL(Domain Specific Language)の仕様

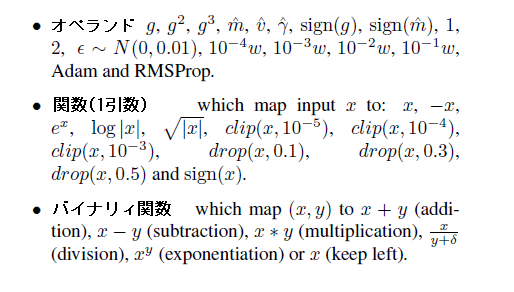

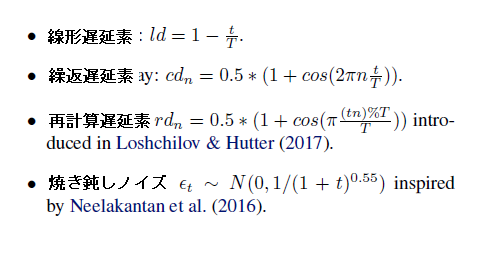

深層学習の重み調整の制御式(DSL)は下記の単位が繋がる形式で学習します。

ここで

はオペレータ

は関数(1引数)

はバイナリィ関数

は学習率

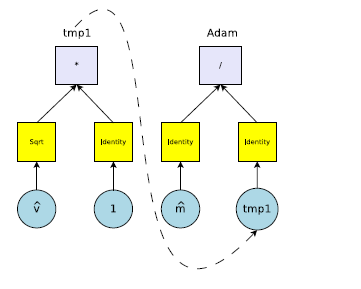

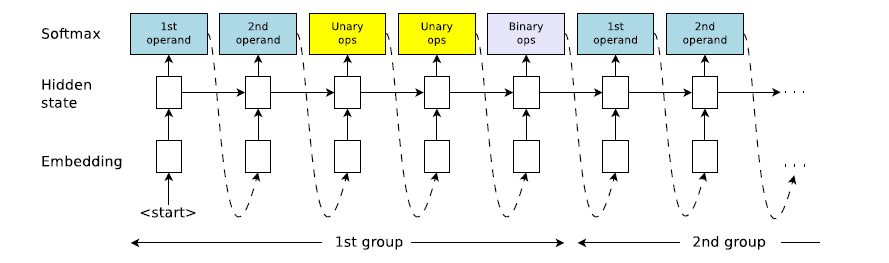

制御式は図示すると次の様な構成となります

以下に各種類の要素があります

2) RNNの構成

制御式は5つの要素が1単位として連結した構成になります。

RNNでは上式は計算順序(逆ポーランド法)になっています。

3)強化学習によるRNNの学習

RNNの強化学習の記述は次式のみです。

ここで

は最大化する目的関数です

は制御式を投入した場合のCNN精度の改善幅を示しています

は制御式の投入確率で

でパラメータ化されています

但しこの強化学習は相当時間がかかるので様々な工夫をしています。

・強化学習モデルはPPO(Proximal Policy Optimization)を採用

・CNNは簡便な学習で済ます(2層、5回繰返)

・組合わせの数はあるので無駄な組合わせを排除

それでも1日費やすとのことです。

(1.2) 結果

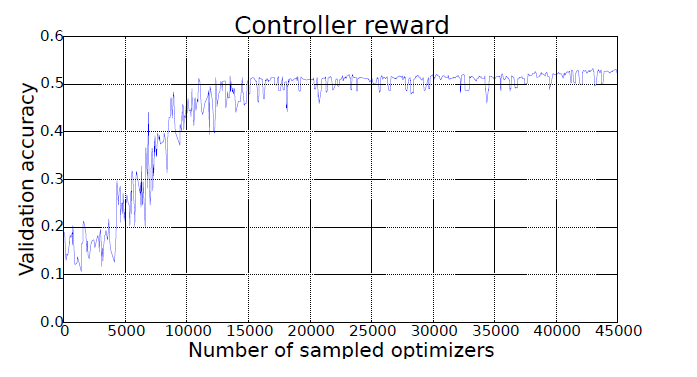

下図が強化学習を繰返しと簡便CNNによる精度の改善状態です。

10000回で収束しています。 データはCIFAR-10 CNN

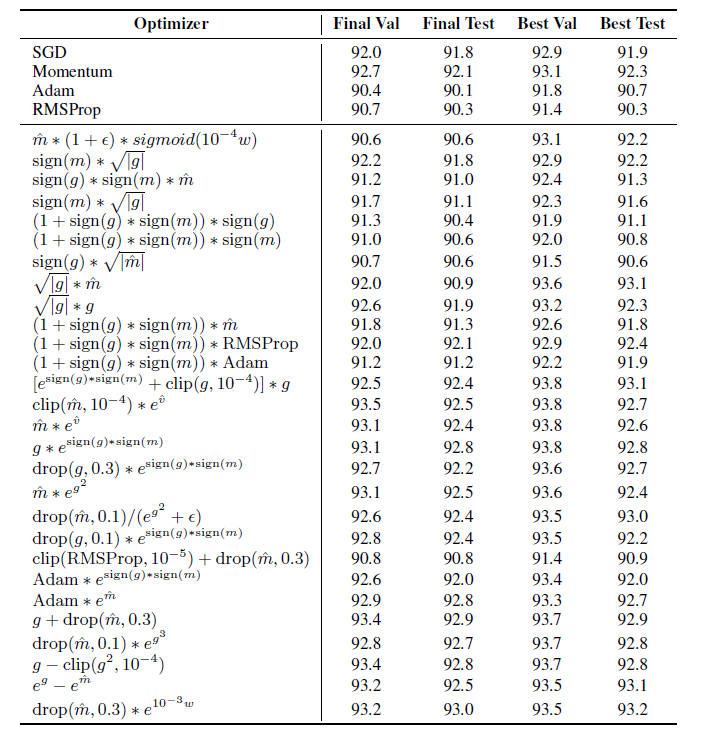

下表の様な重み調整の制御式と精度が達成されています。

識別モデルはwide-ResNet データはCIFAR-10

(1.3) 感想

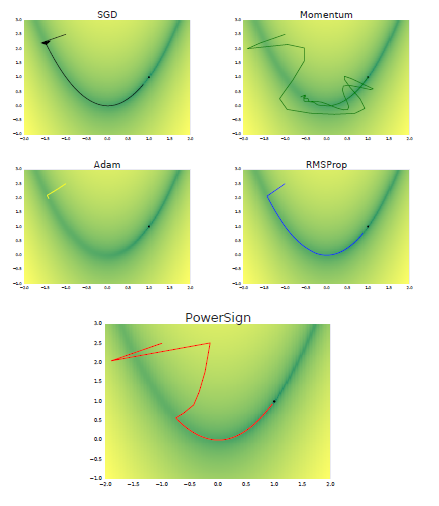

この論文では各制御式での重みの収束軌跡も添付しています。黒点が収束位置です。

素晴らしい成果と思います。この様な重み調整の制御式の試行が深層学習の解明に大きく寄与すると思えます。

DeepMindの外部メモリーによる生成モデルの論文を読む

ランニング30分 英語できず

(1) DeepMindの外部メモリーによる生成モデルの論文を読む

「Variational Memory Addressing in Generative Models」https://arxiv.org/pdf/1709.07116.pdf

この論文は深層学習の生成モデルVAEやGANで成果を出していることに対抗して、DeepMindが得意とする外部メモリを使ったより柔軟な生成モデルを提案したものです。

DeepMindはNTM(Neural Turing Machine)やDNC(Defferencial Neural Computer)で外部メモリーを組み込んだ推論を実現しており、この成果を生成モデルに応用しています。

VAEは生成データと実データの差をパラメータ化して深層学習で解消しますが、一方この論文の手法は外部メモリーに条件を設定し、この条件を満たすVAEを実現するものです。

しかも下図(左)の様に生成データと実データの差を条件とすれば既存のVAEと同じ事が出来、大変柔軟性に富んだ手法となっています。

(1.1) 手法

VAEなので条件Mを満たすを生成する隠れ変数

を変分法で求めます。

変分の下界は次式の右辺で、これが最大になる様にと

を深層学習で訓練します。

ここで

はMemory

の番地

と

は独立と見做せるので上式のサンプリング

の事後分布は次となります。

この論文はと

の事後分布を各々解いています。

1) の事後分布

ここではNTMはDNCでの外部メモリーのキーの学習と同じ考え方を導入しています。

ここで

は外部メモリーの関数

による番地の隠れ変数

は顕在データ

の関数

による隠れ変数

即ちと

の隠れ変数が近くなる様に関数

と

を訓練した結果を

として、これを事後分布

としています。

2) の事後分布

この事後分布はが離散なので簡単に計算できません。

そこでVIMCOというモデルで離散の事後分布を次式の変分で求めています。

ここで は離散のインデックスです

右辺を各々と

を微分して下界を最大化しています。

この辺までの記述になるとかなり式の展開が曖昧になっています。

(1.2) 結果

下図は学習された番地毎のメモリーの状態が示してあり、正解の図

と推定された番地

の画像が近いことが分ります。

PRMLのカルマン・フィルターの理論を理解する

ランニングできず 英語できず

(1) PRMLのカルマン・フィルターの理論を理解する

「PRML §13.3 Linear Dynamic System」

Openposeの多関節の動画は多次元の時系列のため、多次元時系列が解析できる次の開発済みのモデルで性能比較を行うことにしました。

・隠れマルコフ

・カルマンフィルター

・LSTM

・SCW(Soft Confidense Weight)

ここで既存のカルマン・フィルターを古い有本先生のモデルからPRMLのLDSモデルに変更することにしました。ここでPRMLの記述に従ってカルマン・ゲインを使った導出まで行います。

PRMLの最も重大な公式は次の正規分布の周辺分布と事後分布であることはPRMLで随所に参照される公式なので明らかです。

事前分布(2.113)

尤度分布(2.114)

周辺分布(2.115)

事後分布(2.116)

但し

ここで各変数の変遷過程は下図となります。

カルマン・フィルターは観測データから観測前のデータ

を求めるベイズモデルであることが分ります。

ここで

は観測器による変換

は変換器による変遷

これを正規分布に置き換えると

ここで右辺の積分式に(2.115)の周辺分布の公式を使うと

A式

但し

これより観測データから実態データ

を事後分布の公式で計算します。

事前分布 A 式より

尤度分布

上式に(2.117)の事後分布の公式を使うと

①式

但し ②式

ここでPRMLの巻末にある重要な逆行列式の公式(C.7)を使います

(C.7)

ところでMは次のカルマンゲインを使うと③式の様になります。

③式

また②式より

④式

また事後分布①式の平均は③式と④式を入れると

⑤式

最終的に観測値とカルマン・ゲイン

を使って実態

はの平均

と分散

は次式で求められた。

⑤式より

③式より

深層生成による暗黒物質探査の論文を読む

テニス2時間 英語できず

(1)深層生成による暗黒物質探査の論文を読む

「Enabling Dark Energy Science of with Deep Generative Models of Galaxy Images」

https://arxiv.org/abs/1609.05796

宇宙の80%を占めると云われている暗黒物質は宇宙膨張の謎を解く鍵とされていますが、観測が難しいので実態が不明なままです。この実態は下図の黒い部分の様に銀河の光を通して間接的に観測します。具体的には重力レンズという理論で銀河の光の歪みを観測して暗黒物質の規模を推定しています。しかし銀河の光の歪みを計測することも難しいので、VAEやGANを使って銀河の画像を補正しようとする論文です。

(1.1) 手法

ここでは条件付VAEと条件付GANの2種類で銀河の画像を生成しています。

条件付VAEは良く似ていますが半教師学習のSemi-VAEではありません。

画像に一部のみラベルが付いている場合がSemi-VAEです。

データとしては8500個の銀河の画像(64×64)と条件ベクトル

をもつCOSMOSデータで訓練します。

条件ベクトルは3の特徴量(銀河のサイズ、明るさ、宇宙距離)のみです

1) C-VAE(conditional VAE)

VAEなので隠れ変数を仮定します。

は具体的には多変量の平均と分散を表します。

VAEはデータから次の生成モデルの隠れ変数

及びパラメータ

を求めることになります。

隠れ変数を媒介とする変分の教科書は以下なので

ここで

を使った

隠れ変数を使った

の対数尤度の変分は次式で定義できます。

VAEの損失関数が最小となる隠れ変数

及びパラメータ

を深層学習で算出します

2) C-GAN(conditnal GAN)

条件付敵対的生成モデルGANでは次式で定式化できます。

ここで

このGANは隠れ変数の介在で解けないので

で一様乱数としています

は生成器 C-VAEの

を使います

は一般の識別器

(1.2) 結果

COSMOSデータ(特徴量3個)についてRealが銀河の実写で C-VAEとC-GANが生成結果です。

生成結果は何れもノイズが除去されています。

GALAXY-ZOOデータでGANで生成した結果です。但しこのデータの特徴量は37個のベクトルですので、精緻画像が得られています。

深層強化学習によるChatbotモデルの論文を読む

ランニング30分 英語:movie 2012

(1) 深層強化学習によるChatbotモデルの論文を読む

「A Deep Reinforcement Learning Chatbot」https://arxiv.org/abs/1709.02349

この論文はアマゾンの2017年の人工知能モデル競技会で開発された応答会話モデルMILABOTの詳細な報告です。

このモデルはありとあらゆる自然言語モデルと自然言語特徴量の寄せ集めで百科事典的なモデルとなっています。

概要としては以下となります。

・アマゾンが提供する「Amazon Mechanical Turk」で人間による20万件の会話格付を教師データとして利用 Amazon Mechanical Turk – クラウドソーシング用のマーケットプレイス | AWS

・既存の22の会話モデルで応答の候補を生成します。

この22の会話モデルには、次の様々なモデルが組込んであります

用途別(映画/検索)

手法別(テンプレート法/LSTM/機械学習)

また主要なモデルにはアルゴリズムとモデルインストールサイトが添付されています

・応答候補の中で最適な応答が無ければ、強化学習で最優良な応答を選択して返します

・候補応答毎について格付予測を深層学習モデルで行っています

深層学習は自然言語の特徴を1458と14万件の格付の教師データで学習しています。

1458の特徴量の仕様が記述されています

・会話は互いの応答で成立するので、最終会話までの評価をする必要があります。

予測格付を報酬として深層強化学習で最終会話までの累計報酬の価値関数を計算して、

累計報酬の最大価値をもつ応答候補が選択されます

深層強化学習は自然言語の特徴量23個と累計報酬とで価値関数を解いています

ここで

は深層強化学習のパラメータ

は会話(dialog)

は会話の予想格付

は会話暦と選択した応答

概念図としては以下となります。

プレイヤーと環境とが敵対的に学習する論文を読む

ランニングできず 英語できず

(1) プレイヤーと環境とが敵対的に学習する論文を読む

「Learning to Design Games: Strategic Environments in Reinforcement Learning」

https://arxiv.org/abs/1707.01310v2

この論文は強化学習でプレイヤーと活動する環境とが敵対的に競争し合ってプレイヤーの能力を高めるものです。

この論文のコンセプトとして下図を示しています。

一般道の自動運転では様々な連続的に生起する事象を回避する必要があり、その模擬は大変難しいことが知られています。この論文は運転者とその走行環境を互いに複雑にして運転能力を高める方法を開くものと考えられます。

この論文では下図の様にプレイヤーと迷路を敵対的に進化させて同時に学習をすることができています。

(1.1) 手法

強化学習のBellman方程式に敵対的学習を達成するminmaxが定式化されています。

ここで

は遷移確率

のパラメータで報酬を最小化します

はプレイヤーの方策

パラメータで報酬を最大化します

は累計報酬

は状態、行動(前後左右移動)、報酬、割引率です

は遷移確率

は方策

と

は微分して計算して最大傾斜となる値に修正します。

但し、は上式で求めてますが、迷路を複雑にする

は報酬

を最小にする2重の期待値を取る式となっていて相当困難な式が展開されています。 結局擬似プログラムをAppendixに添付しています。

(1.2) 結果

複数のモデルについてプレイヤーと迷路を同時に高度化しています。

ここで

Roundは計算の繰返回数 Returnは迷路での折返し回数です。

OPTはプレイヤーが学習しないモデル

DFSは判断木を生成して深さ優先で最適判断するモデル

RHSは判断木を生成して右方向優先で最適判断するモデル

DQNはDeep Q-learningです

この結果ではDQNのプレイヤーが最適な学習をするので早期に複雑な迷路を生成しています。