DeepMindの多重課題による劣化防止の論文を読む

ランニング30分 英語:Toiec

(1)DeepMindのDeepLearningでの忘却抑止の論文を読む

「Overcoming catastrophic forgetting in neural networks」

ハザビスのサーベイ論文「Neuroscience Inspired AI」でDeepMindの成果として揚げられていたもの。人間は多数の課題に取り組んでいても、直前の課題の成果を忘れることはない。一方ニューラルネットは新しい課題に沿ってパラメータを最適化されると、前の課題にはこのパラメータは適用できない。この問題を解決しょうとしたのが本論文である。

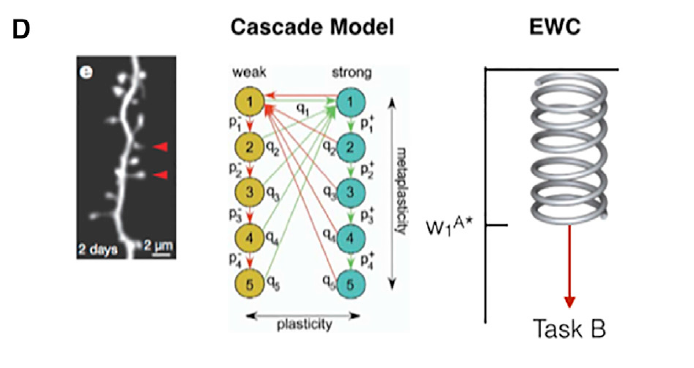

このモデルとしては可塑性加重結合EWC(Elastic Weigtht Consolitation)を提案している。

上図はハザビスの論文のEWCの図であるが、赤矢印の意味は下図の赤矢印の意味である。

イメージとしては、TaskAとTaskBがあり、TaskAの最適化後TaskBへのパラメータの調整を赤色に沿って調整していくものである。即ち最適方向である青色のベクトルを赤と緑に分解して、赤ベクトルだけ採用しようとするものである。

モデルとしては次の簡単な式での事後分布を考えているが、

これは陽に解けないので、事後分布はラプラス近似に近いものを仮定している。

平均:TaskAの平均を使う

分散:フィッシャー情報行列

上記の仮定から、下記の損失関数の最小化を提案している。(ここでは詳細の記述は無い)

ここで

は尤度を示す

はTaskAの学習後の

番目のパラメータを示す

実験としてMINSTの手書き文字の認識を続けて行った場合のEWCによる劣化の抑止が実現できていることを示している。普通のSGDではTask A→B→Cと重なる毎に劣化しているが、EWCでは精度が維持できている。

(2) 言語とロボテックス(ランロボ)の2回目のセミナーに参加する

NIIの稲邑先生が不思議な活動していたので、この発表のみ聞く。

現在の研究はROSを使ったロボテックスの模擬環境の構築である。これは2重の意味でもったいない。

・確かに人間モデルとロボットが3D環境に共存できるのは新しいが、この様な模擬環境はROSがかなりの機能で提供されており、この開発は研究としては弱い。

・模擬環境で実現できた成果は実機では実現できない。これはモータや機器に摩擦があるから、機械学習上の最適化は制御機構の最適化と一致しない所に大きな課題がある。

DeepMindが実機でなく、模擬環境に拘ってモデル開発するのは、計算機が自分で考えるモデルの環境が必要だからであって所謂シンギュラリティを目指している。ロボット工学かシンギュラリティに向かうのか2兎を追うことができるのだろうか。

DeepMindの幼児の視覚理解モデルの論文を纏める

テニス2時間 英語:できず

(1) DeepMindの幼児の視覚理解の論文を読了する

Early Visual Concept Learning with Unsupervised Deep Learning

知識が無い幼児が早期に外界に適応するのは、非教師モデルでしか行えないはずで、生成モデルで理解しているとの論文である。これをKingmaのVAEモデルで視覚理解ができる事を示している。

この実験の結果以下の結論を述べている。

・ガウス分布の隠れ変数のベクトル(位置、拡縮、回転)を視覚データから学習する

・最尤法とVAEの比較では隠れ変数の精度はVAEの方がかなり勝っている

・学習はベクトルの方向毎に行なう方が精度が良く、同時では学習精度が落ちる

・段階的な視覚変化でも、隠れ変数は連続的な推移をしている

・生成モデルなので、経験のない状態でも認識できる。

・アメーバの足の非線形的な変化(シグモイド、2次関数)の変化でも隠れ変数は学習できている。下図は隠れ変数

を連続に変化させ視覚を再現した結果

・VAEモデルなので、Decoderを未知の物体に適応すると所謂Zero-shotである未知の物体の認識が可能になる。

(2) これもDeepMindのハザビスが言及していた。深層学習が前の学習を忘れずに取り戻すモデルの論文を読む。

Overcoming catastrophic forgetting in neural networkshttps://arxiv.org/abs/1612.00796

DeepMindの幼児の早期理解の論文を読む

ランニングできず 英語:Move Starwars

(1)DeepMindのハザビスが問題提起した、幼児が環境を急速に理解する謎についての論文を読む。

[1606.05579] Early Visual Concept Learning with Unsupervised Deep Learning

幼児は知識獲得前なので教師あり(ラベル付)モデルは使えず、非教師モデルとして生成モデルを扱っている。本論文では手書き文字の癖の認識で有名なKingmaのVAE(Varietional Auto Encoder)を使って実験している。

VAEモデル

幼児にはガウス分布の隠れ変数(位置、大きさ、回転)を成分別に獲得する能力があり、視覚的

な訓練によって、隠れ変数を学習するとする理論である。

評価関数は以下でVAEモデルで解く。は隠れ変数

は視覚データ

ここで

は隠れ変数

がガウシアンである依存度で=4が最適

パラメータはVAEのネットワークで最適化する

学習結果として、隠れ変数の分布を増減させた結果を視覚として再現した結果が下記の4~5段目の図である。1から3段目の隠れ変数の増減である。最下段の隠れ変数の分散が小さいので、学習できていることを示している。AとBは視覚データの種別でAは変動要素が1つのもの、Bは複数の変動要素の場合である。Aの左端4つは視覚変動に対して隠れ変数

の分散が大きいので、学習できなかった事を示している。

好奇心を報酬とする理論

ランニング30分 英語できず

(1) 好奇心を報酬とする論文を読了する

[1705.05363] Curiosity-driven Exploration by Self-supervised Prediction

下図の様な迷路ゲーム(Viza-Doom)の場合、迷路の端に報酬があり(右端の図)、各場面では殆ど報酬を見ることができない。現在の最先端の強化学習でも報酬が見つけ難いと殆ど学習ができない。その代替としてこの論文では「好奇心」を報酬としてゲームを解いている。代替報酬としては、「新規差」か「予想の外れ」となるが、本論文では後者を採用している。

好奇心の報酬を「予想との相違」を採用しているが、本当の報酬

との合計をA3C(並列のQ_learning)で方策

の最適化を行っている。

予想との相違である好奇心の報酬は下記で定義

ここで

:予想した次の状態のencode特徴

:実際の次の状態のencode特徴

予想した次の状態の特徴は深層ネットワークで算出する(順モデル)

次の行動予測も別の深層ネットワークで算出する(逆モデル)

ここで各は学習パラメータである。

この好奇心ではDoom迷路での動作は自然な動作を実現していると記述されている。

Doom迷路のデモは以下のGitHubでの実装され人工知能合同研究会でデモが発表された。

この論文の残念な所は、予測した場面と実際の場面の比較に頼っており、実際の場面はゲームでの施行データを使っている。これでは数万回の施行がきず、ランダムに敵が出現する様な複雑な場面では予測と施行データとの比較が困難となると考えられる。残念ながらこの理論では迷路は解けるかもしれないが、シューテイングゲーム版のDoomムは難しいと考えられる。

ゲームDoomの実際の場面と迷路

好奇心を本能的な報酬として解く論文

ランニングできず 英語:Toeic

(1) 好奇心による強化学習の論文を読む。

「Curiosity-driven Exploaration by Self-Supervised Prediction」

明示的な報酬を外生的報酬(extrinsic reward)とし、好奇心を本能的な報酬(instrinsic reward)として区別して、明示的な報酬の期待が少ない場合や定かで無い場合は好奇心を指針にすれば問題が解けるとの論文である。この実験では報酬が見えない場合のゲームでも良好な成績が示されている。

好奇心はには2つあり、「新規差」と「予測との相違」である。前者の新規差はDeepMindのUNREALに場面変異量として既に馴染みがあるが、後者の予測との相違はDeepMindのどのモデルにもない。この論文では後者を採っている、即ち

好奇心=予想と実際が違うのは何故?

下記の結果からは明示的な報酬が殆ど獲得できない状況でもICM(Instrinsic Curiosty Model)本能的な好奇心があると多く明示的報酬が獲得できていることがわかる。

DeepMindの方向性を纏める

テニススクール90分 英語:movie Fully

(1)DeepMindのハザビスの「脳科学とAIの関連」の記事を纏める

「Neuroscience inspiered AI」

何故この様な記事が書いたのか理由の推察であるが、DQNやAlpha碁の偉大な事業を深層強化学習で達成したが、さらに複雑な事象を相手にする場合では既存の手法に限界があり、人間の生存能力としての効率的な認識や理解能力に注目する必要があったためと考えられる。その点、外部記憶を使ったEpisode MemoryやNeural Turing MachineやDCNの成功は正しい戦略だったと云える。一方DeepMindの技術は未だに逆伝播モデルの範疇にあり、このままでは人間の効率的な学習に迫るには不足感を持っている。その点、脳科学では逆伝播に当たる現象は見られず、さらにDeepLearningには無い局所な最適化現象があり、そのギャップを埋める技術に期待を寄せている。

印象としては、GANに代表されるDeepLearningの生成モデルは、数少ない経験から効率的な理解(One-shot)や無体験でも理解(Zero-shot)する能力をうまく説明できると期待しているが、これをGameで実証するためか強化学習の理論寄りから抜け出せていない気がする。

(2)全能アーキテクチャで紹介があったICMの論文に注目する。

「Curiosity-driven Exploration by Self-Supervised prediction」https://arxiv.org/abs/1705.05363

概要を読むと凄い内容のことが書いてある。報酬が殆ど無い場合や、認識できない場合にも一般的に解けるモデルとある。

DeepMind AIの過去・現在・将来の概観記事を読む

ランニング30分 英語できず

引き続きDeepMindハザビスの「AIと脳神経学の関連」の記事を読む。

「Neuroscience-Inspired AI」

次の様なDeepMindが構想するAIを述べており、既に素晴らしい成果であるDQNやAlpha碁を超えて、さらに実用的で複雑な問題を解決あるいは取組んでいる。様々なモデルやアイデアは、これらが脳神経学の知見と近いものがあるとしている。しかしDeepMindとしての主張は、脳神経学を真似るのではなく、問題解決型のAIモデルを作るのに脳神経学を参考にしているという話である。

1)今まで

現在のAIとしての成果が著しいのは、DQNやAlpha碁に見られる様にDeepLearning とRL(強化学習)を統合したDeepRLである。このモデルは一見すると脳神経科学と隔ている様に見えるが、次の4つの分野で強い影響を受けている。

2)現在

2.1) Attention

CNNに見られる様にDeepLearningのネットワークは実データ(画像や音声)を

仕組みとしてAttention(抽象化)する能力がある。これは脳科学の様々な部位の

連携で認識する方法と異なる。

2.2)Episodic Memory

経験(One-shot)の記憶をEpisodeとして外部記憶に置き、これを効率的に

使う方法である。これは脳が睡眠や休憩中に経験を抽象化して蓄積することに

似ている。

2.3)Working Memory

系列記憶のLSTMの拡張として、Neural Turing MachineやDNC(Differencial

Network Computer)は外部記憶上の制御機能で複雑な系列連想を可能にした。

この記事には触れていないが、これは制御機能がLie群多様体での写像になって

いることが後に証明された。

2.4)Continual Learning

人間や動物は過去の事を継続して覚えているが、NeuralNetworkは最適化モデル

なので、前の状態を全て書き換えてしまう。EWC(elastic weight consolidation)

は下図にある様に前の学習状態の重さを弱くして、必要になった場合に強く

して復活させようとするものである。https://arxiv.org/abs/1612.00796

3)これから

3.1)Intuitve Understanding of the Physical World

幼少記に、すぐ適応する仕組みの解明。これには生成モデルが適用でき

これによる隠れ変数は成分(特徴量)を捉えており、これを学習することで

早期の理解が可能になることが示されている。

Early Visual Concept Learning with Unsupervised Deep Learninghttps://arxiv.org/abs/1606.05579

Attend, Infer, Repeat: Fast Scene Understanding with Generative Modelshttps://arxiv.org/abs/1603.08575

3.2)Efficent Learning

数少ない事例から、既存知識を駆使して推論する仕組の解明

Building machines that learn and think like people https://arxiv.org/abs/1604.00289

これも生成モデルを利用したモデルで、見慣れない文字を早期に理解する

DRAW: A Recurrent Neural Network For Image Generationhttps://arxiv.org/abs/1502.04623

いわゆるC.Kempの概念理解

http://mlg.eng.cam.ac.uk/mlss09/mlss_slides/mlss09-tenenbaum-lecture1.pdf

3.3)Transfer Learning

転移学習による、新規知識の一般化

https://rapunselshair.pbworks.com/f/barnett_2002.pdf

人間が経験しなくても、理解できる仕組みの解明

Zero-shothttps://arxiv.org/abs/1707.08475

ロボテックス分野での早期理解

Sim-to-real robot learning from pixels with progressive nets https://arxiv.org/abs/1610.04286

3.4)Imagination and Planning

人間は環境の不明度によって計画や模擬をする能力の仕組みの解明

3.5)Virtutal Brain Analysis

AIは未だにBlackBoxなので実際の脳の複雑な仕組みをAIに適応して解明

4) AIから脳科学へ

DeepLearningが逆伝播(Backpropagation)をして最適化しているのに対して、

脳科学の知見ではこの現象が見られない事に苛立ちを示している。このギャップの

解明を期待している。