DeepMindのUNREALでの暗黙の特徴量

ランニング30分 英語:How the West Won

(1) Deep MindのUNREALを読む。このモデルは迷宮(Labyrinth)Gameを対象としているので、コーナを曲がると別画面になるため、直接に画像から特徴量を抽出するDQNモデルは1部しか使えない。

このモデルでは、様々な暗黙的な特徴量を仮想報酬の計算に使っており、暗黙の特徴量の抽出理論に大きな示唆を与えている。

損失関数はA3Cの損失関数と補助損失関数を合算したものになっている。

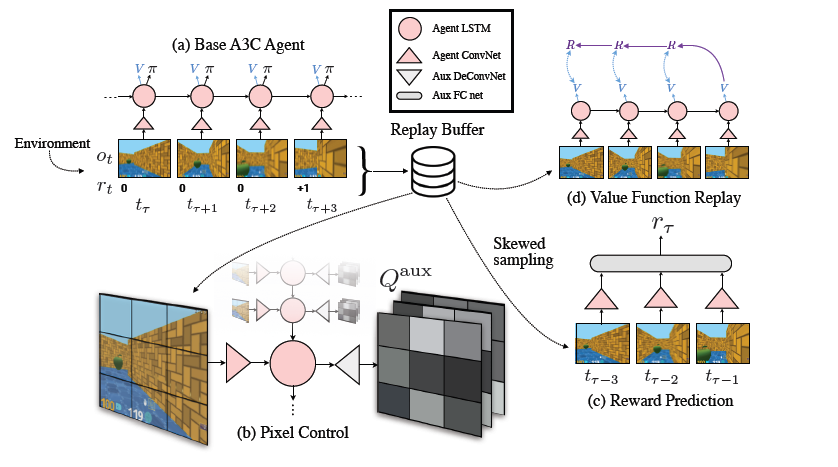

(下記の(a)~(d)は下図の項目に対応している)

(a) A3C(Asynchronous Advantage Actor-Critic):並列型のブースティングで解く

CNN+LSTMで構成されており、方策()とQ関数[Q(s,a)]を解く

(b) PC(Pixel Control):画面変化を仮想報酬としている

報酬がある画面の出現が希である場合、画面の変化が多い行動を報酬とする。

これはDeepMindが提唱する仮想回数を特徴量とするもので、この場合

DeConvolutionで画面を荒くして抽出が容易にしている

(c) RP(Reword Prediction):報酬予測

価値関数に似ているが、これはモデルを安定化するためである。数画面前の

画像から次の画面での報酬を予測するが、この予測は2値(報酬有無)と荒い予測

である。これは人間が報酬を獲得した場面を長く記憶に残す事を真似している。

(d) VR(Value Replay):再現場面の学習

詳細な記述は無いが、過去の同じ場面に近ければ、計算結果を再利用して高速化を

計っている

この損失関数の最適化では、下図の中央にあるReplay Bufferで直近の画面を様々なパラメータ別に保存して、古い画面でのでの学習を避けて安定化と高速化を実現している